Wanneer we zaken doen met bedrijven, nemen systemen een steeds groter deel van de interactie voor hun rekening. Met het Internet of Things worden daar ‘de dingen’ aan toegevoegd. Gaan slimme spullen naar ons luisteren?

Mijn koelkast geeft een piepje als de deur te lang open staat. Maar hij heeft geen idee of ik te lang sta te turen (wat moet er in huis komen?) of dat ik de deur niet goed sluit. Het cliché van de connected koelkast is dat hij zelf proviand bestelt tegen de tijd dat voorraden dreigen op te raken. Maar wie zet de spullen in de koelkast? En houdt de koelkast ook rekening met mijn agenda, namelijk of ik met vakantie ga, of dat ik komende week bezoek krijg dat blijft eten? De afgelopen decennia heeft de koelkast zich niet echt ontwikkeld. Hij luistert niet naar mensen en hij begrijpt ze evenmin.

Slimme spullen zijn er in drie smaken.

Systemen gericht op transacties, zonder intelligentie. Denk aan de geldautomaat, de parkeerautomaat, de OV-chiplezer. Ze maken geen verbinding met het web met het doel daar informatie te selecteren en deze vervolgens aan te bieden. Ze doen dus ook niets met actuele informatie. De OV-chipkaartlezer verwerkt je check-in ook als er door een staking geen treinen rijden. Ze gaan geen interactie aan.

Software die vragen kan afwikkelen met behulp van het internet. De vraag is te zien als een transactie (bel Piet, bestel een pizza, wat is het weer in Amsterdam): de beantwoording komt neer op het combineren van gegevens. Het meest armoedige voorbeeld is de assistent op je smartphone (Siri, Cortana, Google Now, Hound) die je als antwoord op je vraag verwijst naar een website van Google, of naar een contact uit je contactenlijst. De meest bekende virtuele assistenten zijn Siri en GoogleNow. Siri (Apple) luistert sinds een jaar ook naar de Nederlandse taal, maar reageert alleen op de uitspraak “Hey Siri” als het Apple-apparaat aan het opladen is of als je de ‘home’-knop indrukt. Google Now reageert altijd op het commando “OK Google”. Beide assistenten kunnen nog weinig regelen, ze zijn vooral goed in opzoeken. Bij wat ingewikkelder zoekopdrachten gaat spreken een stuk sneller dan intikken; dat lijkt veelbelovend voor online shopping.

Spraak is de meest natuurlijke vorm van communiceren; praten is echter zowel voor mensen als systemen een stuk gemakkelijker dan luisteren. De personal assistent Amazon Echo is een ‘slimme’ luidspreker die onderdak biedt aan Alexa, een assistent die met je meeluistert. Alexa, die verder geen gezicht heeft, gaat een stuk verder dan de Dash button van Amazon, waarbij je via een druk op een knop op je wasmachine wasmiddel kan aankopen – een fysieke shortcut naar de juiste plek in een webshop. Alexa gaat de interactie aan met informatie en indien nodig met de omgeving: ze somt de headlines voor je op, dimt het licht als je daarom vraagt, zet een timer als je een pizza in de oven zet. Maar ze leert niet van je gewoonten: eigen patronen (elke dag de headlines bij je ontbijt) zal je moeten herhalen of programmeren. Ook andere slimme systemen proberen aan te haken op (onderdelen van) het internet of things. iOS zet in op Home Kit, waarbij verschillende soorten hardware en software samenwerken. Zo zijn er verschillende ecosystemen en daarbovenop bouwen ontwikkelaars apps die platformen koppelen (zoals IFTTT).

Van links naar rechts: Siri, Sophie, Ask Google, Amelia en Cortana.

Software die proactief tegen jou praat en daarbij alles uit jouw leven in de communicatie betrekt. De smartphone is hiervoor uiteraard de beste basis, want die weet meer van je dan je partner. De smartphone heeft informatie over waar je op welk moment bent – en in veel gevallen ook wat je doet, zoals met wie je communiceert en waarover – en heeft inzicht in je data- en softwaregebruik. Wanneer je smartphone actief naar jou en je omgeving zou luisteren en proactief zou kunnen interacteren, dan ontstaan mogelijkheden die richting uncanny valley gaan. Je smartphone zou je kunnen waarschuwen bij te grote uitgaven, zou je wijzen op interessante en relevante aanbiedingen van winkels waar je fysiek langs loopt, zou al je gesprekken kunnen volgen en kunnen refereren aan iets wat je een week geleden tegen je partner hebt gezegd: je had je voorgenomen je moeder te bellen, hoe zit dat? Deze software zou uit je aankoopgedrag kunnen afleiden wanneer nieuwe hardware het huis in komt en al vast met instructies of een tutor kunnen komen. Luisterend naar sensoren en RFID-chips zou zo’n systeem kunnen vragen of bepaalde levensmiddelen moeten worden besteld, en het onthouden als je altijd ‘ja’ zegt; maar wel rekening houden met je agenda: staan er nog vakanties gepland? Deze software beperkt zich niet tot communiceren, maar acteert ook en neemt dus zelfstandig beslissingen met financiële en fysieke gevolgen: voor bestellingen (op tijd een bosje bloemen laten bezorgen) of voor het gedrag van voorwerpen (op tijd de verwarming opstoken, omdat duidelijk is dat je onderweg naar huis bent). Net als bij de zelfsturende auto zullen we in complexe situaties rekening moeten houden met fouten of vertragingen in de besluitvorming.

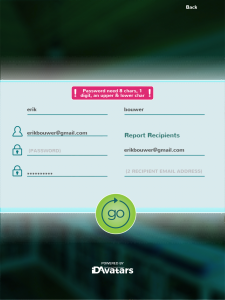

Techneuten hopen de interactie met onze omgeving slimmer te maken door lerend vermogen aan de software toe te voegen. X.ai blijft  daarbij op de achtergrond, maar kan wel het beheer van je agenda regelen; met Viv willen de uitvinders van Siri een stap verder gaan en MindMeld wil het mogelijk maken om het internet met spraak te besturen. De ontwikkelaars van ID Avatars hopen samen met IBM’s Watson empathische chatbots te kunnen realiseren; in de appstore kan je AskSophie downloaden en installeren, maar de registratieprocedure belooft niet veel goeds. EasilyDo zoekt naar relevante zaken in je agenda, je e-mail en je social media maar biedt naast enig gemak geen zekerheden.

daarbij op de achtergrond, maar kan wel het beheer van je agenda regelen; met Viv willen de uitvinders van Siri een stap verder gaan en MindMeld wil het mogelijk maken om het internet met spraak te besturen. De ontwikkelaars van ID Avatars hopen samen met IBM’s Watson empathische chatbots te kunnen realiseren; in de appstore kan je AskSophie downloaden en installeren, maar de registratieprocedure belooft niet veel goeds. EasilyDo zoekt naar relevante zaken in je agenda, je e-mail en je social media maar biedt naast enig gemak geen zekerheden.

Er is nog een lange weg te gaan om intelligente conversaties aan te gaan met of namens voorwerpen. Virtuele assistenten zouden hiervoor ‘the man in the middle’ kunnen zijn. Het enthousiasme voor spraakbesturing groeit echter wel. Watson (IBM) en Amelia (IPsoft) zijn nog steeds primair rekenwonders. Ze maken wel nieuwe combinaties van bestaande informatie, maar zullen nooit een fluitconcert voor vogels componeren zonder dat iemand daar de opdracht toe geeft – een kenmerk van creativiteit. Ze zullen bij hun beslissingen ook geen rekening houden met hoe jij of jouw partner zich voelt – een kenmerk van empathie.

Zelfs het omgaan met opdrachten is al een hele uitdaging bij het ontwerpen van lerende systemen. Tay.ai, een geautomatiseerde chatbot van Microsoft, werd na een paar dagen offline gezet omdat gebruikers het digitale wezen hadden getraind op het doen van racistische uitspraken. Lerend vermogen is te ontwikkelen, ook voor kunstmatige systemen. Empathie – gevoel voor de context – is een stuk lastiger.

of de app met laadpalen correcte informatie geeft. Het grootste deel van de organisaties waarmee we zaken doen, heeft geen idee wie we zijn als we bellen – ze volgen ons niet. Als we als klant vastlopen in ‘intelligente’ selfservice, zijn we alsnog afhankelijk van een customer service agent. Die agent heeft vervolgens ons, de klant, nodig om het probleem opgelost te krijgen. Bijvoorbeeld om informatie te geven over variabelen die alleen wij kunnen waarnemen: de context. Denk aan het gedrag van andere onderdelen uit een keten of aan invloeden van buitenaf. Een goed voorbeeld is de zorgketen. Omdat verzekeraar A een administratieve achterstand heeft, kan verzekeraar B de nieuwe overstappende klant nog niet verwerken. In dat geval is de klant de intermediair tussen ‘dom’ product en leverancier. Wil je een geautomatiseerd systeem leren omgaan met de doorlopend veranderende context, dan ben je eigenlijk op zoek naar een systeem dat real time en intelligent met de buitenwereld kan omgaan.

of de app met laadpalen correcte informatie geeft. Het grootste deel van de organisaties waarmee we zaken doen, heeft geen idee wie we zijn als we bellen – ze volgen ons niet. Als we als klant vastlopen in ‘intelligente’ selfservice, zijn we alsnog afhankelijk van een customer service agent. Die agent heeft vervolgens ons, de klant, nodig om het probleem opgelost te krijgen. Bijvoorbeeld om informatie te geven over variabelen die alleen wij kunnen waarnemen: de context. Denk aan het gedrag van andere onderdelen uit een keten of aan invloeden van buitenaf. Een goed voorbeeld is de zorgketen. Omdat verzekeraar A een administratieve achterstand heeft, kan verzekeraar B de nieuwe overstappende klant nog niet verwerken. In dat geval is de klant de intermediair tussen ‘dom’ product en leverancier. Wil je een geautomatiseerd systeem leren omgaan met de doorlopend veranderende context, dan ben je eigenlijk op zoek naar een systeem dat real time en intelligent met de buitenwereld kan omgaan. Een derde reden is dat innovatie van diensten en producten in veel gevallen precies beperkt blijft tot die diensten en producten. De Tesla is een geweldige auto, maar hij is nog niet in staat het opladen zo te organiseren dat de gebruiker er geen last van heeft. Bij

Een derde reden is dat innovatie van diensten en producten in veel gevallen precies beperkt blijft tot die diensten en producten. De Tesla is een geweldige auto, maar hij is nog niet in staat het opladen zo te organiseren dat de gebruiker er geen last van heeft. Bij

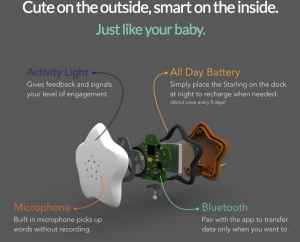

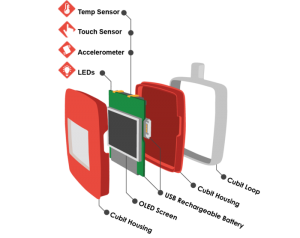

Om de groei en ontwikkeling van je kind te bewaken kan je aan de slag met

Om de groei en ontwikkeling van je kind te bewaken kan je aan de slag met  Vorig jaar werd op CES het internet of pets (IoP) geïntroduceerd. FitBark, PetPace, Nuzzle en

Vorig jaar werd op CES het internet of pets (IoP) geïntroduceerd. FitBark, PetPace, Nuzzle en  Fisher Price, ook bekend van

Fisher Price, ook bekend van  De agrarische sector is al een paar stappen verder en maakt naast smart tags ook gebruik van smart pills.

De agrarische sector is al een paar stappen verder en maakt naast smart tags ook gebruik van smart pills.

vrouwelijke luchtvaartpionier

vrouwelijke luchtvaartpionier

Is wearable computing daarmee niet meer dan een tussenfase? Wearables lijken iets nieuws, maar ver voordat de eerste geavanceerde GSM-toestellen waarop je al e-mail versturen en ontvangen werden gelanceerd, waren er al polshorloges met ingebouwde rekenmachines. En we zijn al sinds 2010 blij dat de iPad bestaat, maar de eerste commerciële tablet-pc’s werden al eind jaren 90 geïntroduceerd. Niets nieuws dus. Het zijn vooral formaat en connectiviteit die veranderen. Daarnaast zijn de meeste innovatiepogingen er vooral op gericht om IT

Is wearable computing daarmee niet meer dan een tussenfase? Wearables lijken iets nieuws, maar ver voordat de eerste geavanceerde GSM-toestellen waarop je al e-mail versturen en ontvangen werden gelanceerd, waren er al polshorloges met ingebouwde rekenmachines. En we zijn al sinds 2010 blij dat de iPad bestaat, maar de eerste commerciële tablet-pc’s werden al eind jaren 90 geïntroduceerd. Niets nieuws dus. Het zijn vooral formaat en connectiviteit die veranderen. Daarnaast zijn de meeste innovatiepogingen er vooral op gericht om IT

Je zou verwachten dat fabrikanten van smartwatches hierop aanhaken, zoals de

Je zou verwachten dat fabrikanten van smartwatches hierop aanhaken, zoals de