IBM heeft besloten om superslimme computer Watson naar de cloud te verhuizen en zijn rekenkracht te verdubbelen, zo berichtte AG half januari. Hiermee wil IBM nieuwe mogelijkheden scheppen voor AI-as-a-service: kunstmatige intelligentie op afroep, bijvoorbeeld voor big data analyses en linguïstiek. Hoewel beide zaken weinig te maken hebben met AI – van klein denken is nog nooit iemand groot geworden, en van snel rekenen word je niet echt intelligenter – biedt de cloud wel een mooi platform om technologieën die rekenkracht en -snelheid nodig hebben een kans van slagen te bieden.

Vice president Stephen Gold, betrokken bij de Watson-activiteiten van IBM, voorspelt dat toekomstige generaties op 2013 zullen terugblikken als het jaar van ‘een monumentale verandering’. Hij doelt daarmee wellicht op de mogelijkheden van Watson op het gebied van verwerking van natuurlijke taal.

Het inzetten van natuurlijke taal in de automatisering wordt al enkele decennia gezien als een veelbelovende technologie. Zo ongeveer iedere vijf jaar werd door leveranciers, ontwikkelaars en goeroes geroepen dat de komende vijf jaar toegepaste technologieën zoals spraakherkenning zouden doorbreken. Maar spraaktechnologie is net zo breed inzetbaar als het jongere broertjes touch technologie. Soms is het handig om tegen apparaten te spreken, soms is het handiger te aan te raken. Spraaktechnologie is wel verbeterd door goedkopere en snellere rekenkracht en verder ontwikkelde software en er zijn meer succesvolle toepassingen ontstaan, waarvan Siri (geïntroduceerd in oktober 2011 op de iPhone 4S) en Glass mooie voorbeelden zijn. Maar om nu te zeggen dat spraakherkenning mainstream is sinds Siri? Ik mis daarvoor zowel de cijfers als de hype rondom het gebruik van Siri. Ook Google Glass, aangestuurd met basale commando’s, moet nog een hele weg afleggen. In het algemeen werkt spraakherkenning beter naarmate het systeem meer getraind is in het herkennen van een bepaalde stem (of bepaalde klanken). Systemen luisteren dus na verloop van tijd vooral goed naar hun baasje, maar zelfs marktleider Nuance heeft voor dat trainingsvraagstuk nog geen oplossing.

Een spraakherkenningssysteem werkt onder andere op basis van waarschijnlijkheid en die wordt steeds groter naarmate er meer data beschikbaar zijn om waarnemingen te vergelijken met opgeslagen kennis. In dit opzicht zou de cloud een belangrijke rol kunnen gaan spelen. Daarnaast is voor het kunnen werken met natuurlijke taal data over de context nodig. Ook hier kan de cloud meerwaarde bieden, want als er ergens ‘context’ beschikbaar is, dan is dat wel in de cloud, waar we doorlopend informatie in opslaan en van waaruit veel apps werken. Met behulp van een 4G verbinding zou Siri real time informatie kunnen ophalen uit de cloud, onder meer via anticiperende systemen als Google Now.

Wanneer gesteld wordt dat 2014 het jaar van de spraakherkenning wordt, heb ik zo mijn twijfels. Het zou ook zo maar 2015 of 2016 kunnen worden. Maar voor een geleidelijke doch stevige ontwikkeling van technologie en in praktische toepassingen is zo langzamerhand wel aan alle voorwaarden voldaan. Spraakherkenning heeft inmiddels een goed imago. Er ontstaan steeds meer devices die in specifieke omstandigheden goed met spraak zouden kunnen worden bediend. Steeds meer apparaten (wearables, maar ook ingebouwde systemen) zijn gemakkelijk te bedienen met spraak – en ook in professionele omgevingen leidt spraaktechnologie tot slimme oplossingen. Daarnaast groeit de behoefte aan nieuwe security-oplossingen op het gebied van identificatie en authenticatie, onder meer bij banken. Tot slot worden devices zoals tablets en smartphones zelf ook steeds krachtiger. De cloud als data hub tenslotte gaat wat mij betreft de doorslag geven.

Deze post is tot stand gekomen in samenwerking met de Zero Distance community en T-Systems

[wp_twitter]

Bijna alle telecomspelers, maar ook software- en hardware-leveranciers leveren cloudopslag. Koop een

Bijna alle telecomspelers, maar ook software- en hardware-leveranciers leveren cloudopslag. Koop een  Het is niet verwonderlijk dat er nog geen keurmerk of standaard is voor cloud diensten gericht op consumenten. Eerst moet er nog veel gebeuren voor de zakelijke markt, waar nog volop wordt gewerkt aan

Het is niet verwonderlijk dat er nog geen keurmerk of standaard is voor cloud diensten gericht op consumenten. Eerst moet er nog veel gebeuren voor de zakelijke markt, waar nog volop wordt gewerkt aan

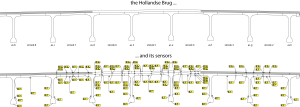

en vracht moet worden afgestemd op beschikbare vliegtuigen. Die complexe operatie vergt veel coördinatie en communicatie tussen allerlei partijen: luchthavenexploitant, luchtvaartmaatschappijen, vliegveiligheidsdienst, dienstverleners zoals afhandelings-, catering- en schoonmaakbedrijven en verschillende autoriteiten. Vliegtuigen die niet vertrekken, kosten geld: resources op de grond worden geblokkeerd en luchtvaartmaatschappijen moeten passagiers bij langere vertragingen schadevergoedingen betalen: beginnend bij bedragen vanaf 250 euro per passagier na drie uur.

en vracht moet worden afgestemd op beschikbare vliegtuigen. Die complexe operatie vergt veel coördinatie en communicatie tussen allerlei partijen: luchthavenexploitant, luchtvaartmaatschappijen, vliegveiligheidsdienst, dienstverleners zoals afhandelings-, catering- en schoonmaakbedrijven en verschillende autoriteiten. Vliegtuigen die niet vertrekken, kosten geld: resources op de grond worden geblokkeerd en luchtvaartmaatschappijen moeten passagiers bij langere vertragingen schadevergoedingen betalen: beginnend bij bedragen vanaf 250 euro per passagier na drie uur.

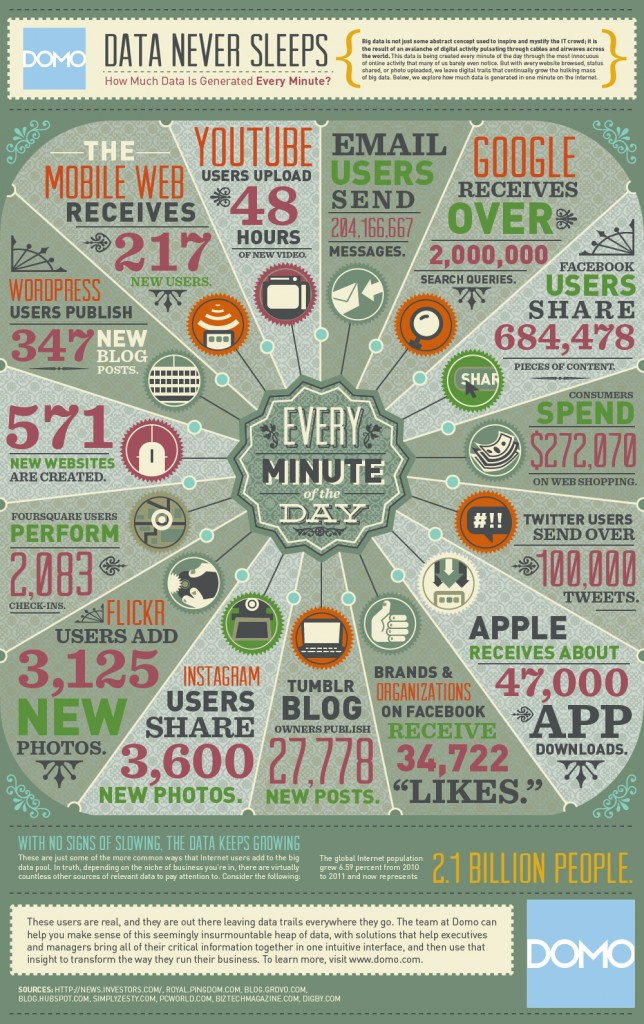

De feiten rondom big data zijn helder. Het datavolume groeit snel en op veel gebieden (denk aan de zorg) explosief. De toekomst biedt weliswaar geen feitelijke zekerheden, maar dat de groei sterk zal doorzetten valt niet te betwijfelen. Alleen al het mobiele dataverkeer neemt tot 2019 met 45 procent toe, aldus het laatste

De feiten rondom big data zijn helder. Het datavolume groeit snel en op veel gebieden (denk aan de zorg) explosief. De toekomst biedt weliswaar geen feitelijke zekerheden, maar dat de groei sterk zal doorzetten valt niet te betwijfelen. Alleen al het mobiele dataverkeer neemt tot 2019 met 45 procent toe, aldus het laatste

Wanneer je het vliegtuig naar de VS neemt, weet de NSA vermoedelijk sneller wat jij aan boord hebt gegeten dan dat de cabin crew het aan je heeft gevraagd. Passenger Name Records moeten door vliegmaatschappijen beschikbaar worden gesteld aan de VS, die afspraak is nu eenmaal gemaakt, maar het afluistervraagstuk plaatst internationale afspraken en wet- en regelgeving in een ander perspectief. Onze banken worstelen echter al langere tijd met het datavraagstuk en met vergelijkbare wetten en regels met een eveneens twijfelachtige werking.

Wanneer je het vliegtuig naar de VS neemt, weet de NSA vermoedelijk sneller wat jij aan boord hebt gegeten dan dat de cabin crew het aan je heeft gevraagd. Passenger Name Records moeten door vliegmaatschappijen beschikbaar worden gesteld aan de VS, die afspraak is nu eenmaal gemaakt, maar het afluistervraagstuk plaatst internationale afspraken en wet- en regelgeving in een ander perspectief. Onze banken worstelen echter al langere tijd met het datavraagstuk en met vergelijkbare wetten en regels met een eveneens twijfelachtige werking. se overheid (officieel na toestemming van de rechter) de mogelijkheid biedt om data op te vragen van Amerikaanse burgers en bedrijven, ongeacht waar die zich bevinden. Aan de andere kant dragen Nederlandse organisaties vanuit Nederlandse en Europese wetgeving zelf de verantwoordelijkheid voor een correctie verwerking en bescherming van persoonsgegevens. Wanneer Europese banken zaken doen met internationale dienstverleners, wordt de wet- en regelgeving alleen maar complexer. Niet-Europese dienstverleners moeten verklaren dat zij de Europese wet- en regelgeving respecteren. Hun datacenters moeten bijvoorbeeld binnen Europa gevestigd zijn, zodat voorkomen kan worden dat een vestigingsland (buiten Europa) via eigen wet- en regelgeving kan bepalen hoe er wordt omgegaan met data. Datacenters zijn relevant voor de opslag van klantgegevens. Van grote financiële instellingen is vrijwel nooit bekend waar zij welke data onderbrengen.

se overheid (officieel na toestemming van de rechter) de mogelijkheid biedt om data op te vragen van Amerikaanse burgers en bedrijven, ongeacht waar die zich bevinden. Aan de andere kant dragen Nederlandse organisaties vanuit Nederlandse en Europese wetgeving zelf de verantwoordelijkheid voor een correctie verwerking en bescherming van persoonsgegevens. Wanneer Europese banken zaken doen met internationale dienstverleners, wordt de wet- en regelgeving alleen maar complexer. Niet-Europese dienstverleners moeten verklaren dat zij de Europese wet- en regelgeving respecteren. Hun datacenters moeten bijvoorbeeld binnen Europa gevestigd zijn, zodat voorkomen kan worden dat een vestigingsland (buiten Europa) via eigen wet- en regelgeving kan bepalen hoe er wordt omgegaan met data. Datacenters zijn relevant voor de opslag van klantgegevens. Van grote financiële instellingen is vrijwel nooit bekend waar zij welke data onderbrengen. IT van banken. In de Wet Financieel Toezicht (WFT) en de Pensioenwet is vastgelegd dat

IT van banken. In de Wet Financieel Toezicht (WFT) en de Pensioenwet is vastgelegd dat  versneld gaan inspelen op regelgeving, wordt dat aantrekkelijk voor klanten. Het vergroot tegelijkertijd de complexiteit: dienstverleners zullen namelijk sterker moeten inspelen op uiteenlopende omstandigheden van verschillende lokale markten. Of de verschillende nationale toezichthouders eenzelfde beweging zullen maken en zullen streven naar geharmoniseerde regelgeving, valt te betwijfelen. Daarvoor zijn de verschillen in nationale wet- en regelgeving op het vlak van levensverzekeringen en pensioenen nog veel te groot.

versneld gaan inspelen op regelgeving, wordt dat aantrekkelijk voor klanten. Het vergroot tegelijkertijd de complexiteit: dienstverleners zullen namelijk sterker moeten inspelen op uiteenlopende omstandigheden van verschillende lokale markten. Of de verschillende nationale toezichthouders eenzelfde beweging zullen maken en zullen streven naar geharmoniseerde regelgeving, valt te betwijfelen. Daarvoor zijn de verschillen in nationale wet- en regelgeving op het vlak van levensverzekeringen en pensioenen nog veel te groot.

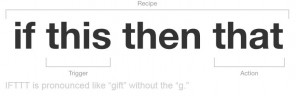

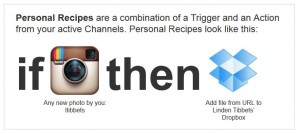

Met platforms zoals IFTTT krijgt domotica een consumerized tintje: het zijn niet langer de hardware- en software-boeren die IoT-functionaliteit leveren: denk aan de zonwering of verwarmingsthermostaat thuis die je vanaf je werk met je mobiel kunt bedienen. Of een meer praktisch voorbeeld van GE, die een

Met platforms zoals IFTTT krijgt domotica een consumerized tintje: het zijn niet langer de hardware- en software-boeren die IoT-functionaliteit leveren: denk aan de zonwering of verwarmingsthermostaat thuis die je vanaf je werk met je mobiel kunt bedienen. Of een meer praktisch voorbeeld van GE, die een