Het wordt ook wel de vierde industriële revolutie genoemd: de totale digitalisering van de samenleving. In de digitale economie doen mensen steeds vaker zaken met systemen, software en algoritmen in plaats van met andere mensen. Kunstmatige intelligentie staat daarbij centraal. Binnenkort staan we voor de vraag of we accepteren dat een robot beschikt over kunstmatige emotionele intelligentie.

Het wordt ook wel de vierde industriële revolutie genoemd: de totale digitalisering van de samenleving. In de digitale economie doen mensen steeds vaker zaken met systemen, software en algoritmen in plaats van met andere mensen. Kunstmatige intelligentie staat daarbij centraal. Binnenkort staan we voor de vraag of we accepteren dat een robot beschikt over kunstmatige emotionele intelligentie.

Na de efficiencyslag van de derde industriële revolutie (de opkomst van de eerste automatiseringsgolf) brengt ook de vierde industriële revolutie veel kansen met zich mee. Met data als grondstof en software als machine kunnen we informatie veel beter benutten. De keerzijde is dat hardware en software zich zo snel hebben ontwikkeld, dat computers ook veel taken kunnen overnemen die voorheen exclusief aan mensen waren voorbehouden. Optimisten stellen dat iedere technologische revolutie voor het verdwijnen van banen heeft gezorgd, maar ook nieuwe werkgelegenheid heeft gecreëerd. Sommigen hebben het bij die vierde revolutie over nieuwe banen zoals ‘head of humanity’ – want ook voor de verdere ontwikkeling van kunstmatige intelligentie zijn mensen nodig.

Van hulpmiddel naar vervanger

In zijn boek ‘The Rise of the Robots’ legt Martin Ford haarfijn uit waarom de vierde industriële revolutie anders is dan de voorgaande drie revoluties. De computer verandert de komende jaren van een ‘complementair hulpmiddel’ in een ‘vervanger’ van de mens. Het ontstaan van nieuwe technologiebanen kan niet compenseren dat grote groepen op de arbeidsmarkt – inclusief hoogopgeleide kenniswerkers – hun voorsprong op de computer zullen verliezen. Ford is relatief behoudend: hij voorspelt dat kunstmatige intelligentie over tien tot twintig jaar tot maatschappelijke ontwrichting zal leiden door grootschalig verlies van werkgelegenheid. Hij zegt er meteen bij dat veel Silicon Valley-ondernemers denken dat die toekomstscenario’s al over vijf tot tien jaar aan de orde zijn.

We doen al jaren zaken met systemen

Het grote onderscheid tussen mensen en kunstmatige intelligentie is dat de laatste variant nog niet beschikt over empathisch vermogen en evenmin in staat is creatief te denken. Daarom lijkt de computer vooralsnog geen bedreiging voor beroepen waar intensieve interactie met mensen centraal staat – iets wat ook Ford in zijn boek betoogt. Maar hoe belangrijk ze ook mogen zijn, de interacties tussen mensen (klant en leverancier, patiënt en arts, student en docent) bevatten ook altijd eenvoudiger, repeterende en routinematige elementen. Veel daarvan is in de afgelopen jaren al geautomatiseerd: denk aan het zelf inchecken van passagiers en bagage bij luchthavens, de ontwikkeling van online selfservice bij klantenservice, de opkomst van e-learning en het zelf regelen van bankzaken via apps en websites. Ook het ingewikkelde werk aan de ‘achterkant’ van die interactie – zoals het verwerken van schadeclaims of het opstellen van analyses en adviezen – wordt in toenemende mate geautomatiseerd. Wat overblijft, zijn de interacties tussen mensen waar onvoorspelbaarheid, creativiteit en empathie een rol spelen. Je kunt het ook omdraaien: waar de huisarts nu nog zelf een diagnose stelt, kan hij straks terugvallen op een systeem en wordt zijn taak beperkt tot het tonen van empathie. Totdat kunstmatige emotionele intelligentie zijn intrede doet.

De computer begrijpt wat ik bedoel

Of we het als mens accepteren dat ‘systemen’ onze emoties en intenties gaan begrijpen, is de vraag, maar er wordt in ieder geval aan gewerkt. Watson Engagement Advisor – ja, een telg uit de IBM Watson kwekerij – is in staat in natuurlijke taal te communiceren. Watson heeft daarvoor 300 miljoen Engelse woorden gelezen en begrijpt natuurlijke taal inclusief de nuances. Watson gebruikt bovendien deep learning. IBM stelt dat dit alles voldoende is voor het herkennen van de achterliggende intentie van een vraag, ongeacht hoe die vraag wordt gesteld.

In bovenstaand voorbeeld – can I change my flight? – is het de intentie dat de vlucht wordt gecancelled. Watson kan uiteraard veel aanvullende vragen stellen om dichter bij de juiste beslissing te komen – ben je een trouwe klant? Zijn er nog andere zaken om rekening mee te houden? Wat moet Watson bijvoorbeeld doen als de klant meldt dat hij een fervent blogger is? Wanneer Watson tot het inzicht komt dat hij niet alle informatie met voldoende zekerheid kan verwerken, zet hij de vraag door naar een menselijke collega. Watson kan rationeel gezien dus een heel eind komen, maar mist nog wel dat wat hem onderscheidt van mensen: emotionele intelligentie.

De computer begrijpt wat ik voel

Juist in intensieve interacties tussen mensen is empathie een van de belangrijkste zaken om tot het juiste begrip van de ander te komen. Wanneer systemen in staat zijn de juiste ‘emotionele’ informatie te verzamelen – denk bijvoorbeeld aan de ooguitdrukking, spraaksnelheid en volume, lichaamshouding – kunnen ook zij tot een beter begrip komen. Deze tweede tak van sport wordt affective computing genoemd – of kunstmatige emotionele intelligentie. Analistenbureau Markets and Markets voorspelt dat de markt voor affective computing over drie jaar (in 2020) 42 miljard dollar zal omvatten. De belangrijkste toepassingsgebieden: retail, zorg, overheid en defensie; met name op die plaatsen waar informatie moet worden verzameld, waar wordt samengewerkt en waar informatie wordt verstrekt. Tien jaar geleden verschenen de eerste houterige chatbots op het toneel. Virtuele assistenten of chatbots zijn tegenwoordig in staat om op basis van tekst het sentiment in een dialoog met een mens te beoordelen.

Kunstmatige emotionele intelligentie

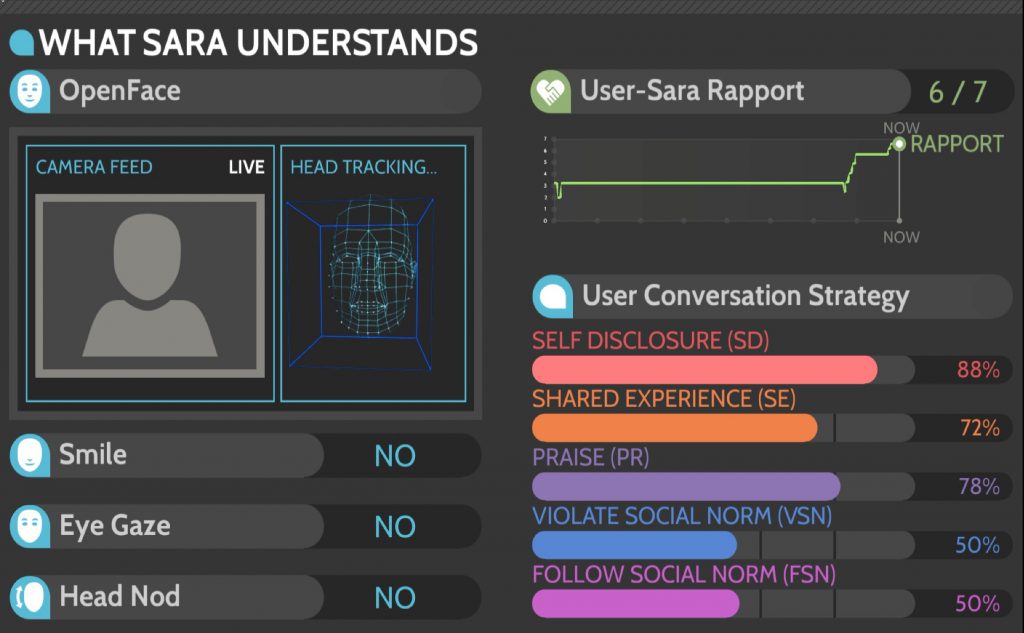

Op dit moment wordt op Carnegie Mellon University hard gewerkt aan de eerste ‘chatbot met sociaal inzicht’, genaamd SARA. Die naam staat voor Socially-Aware Robot Assistant en SARA is in staat om sociaal gedrag te herkennen in conversaties. SARA verwerkt realtime visuele informatie (lichaamstaal, gelaatsuitdrukking), intonatie, volume en snelheid van de spraak en verbale informatie (spraakherkenning) van de gesprekspartner. Bij het bepalen van de respons wordt er zowel rationeel als sociaal geanalyseerd. Wat is de beste oplossing voor het vraagstuk dat is voorgelegd? En wat is de beste manier om de respons te geven: met welke gelaatsuitdrukking, lichaamstaal en stemgebruik? Daarna wordt de respons via een Natural Language Generation module uitgesproken op een manier die aansluit bij de gesprekspartner.

Op dit moment wordt op Carnegie Mellon University hard gewerkt aan de eerste ‘chatbot met sociaal inzicht’, genaamd SARA. Die naam staat voor Socially-Aware Robot Assistant en SARA is in staat om sociaal gedrag te herkennen in conversaties. SARA verwerkt realtime visuele informatie (lichaamstaal, gelaatsuitdrukking), intonatie, volume en snelheid van de spraak en verbale informatie (spraakherkenning) van de gesprekspartner. Bij het bepalen van de respons wordt er zowel rationeel als sociaal geanalyseerd. Wat is de beste oplossing voor het vraagstuk dat is voorgelegd? En wat is de beste manier om de respons te geven: met welke gelaatsuitdrukking, lichaamstaal en stemgebruik? Daarna wordt de respons via een Natural Language Generation module uitgesproken op een manier die aansluit bij de gesprekspartner.

Software is eating the world

Gaan mensen accepteren dat een robot invoelend gedrag vertoont? De attitude ten aanzien van nieuwe technologie kan snel veranderen zoals dit beroemde filmpje uit 1999 laat zien. De acceptatie van ‘kunstmatige intelligentie met gevoel’ zal afhangen van kwaliteit, geloofwaardigheid en vertrouwen. We zijn de afgelopen jaren al een heel eind opgeschoven van mensen naar machines: denk aan bankzaken (van kasmedewerker tot mobiele app), informatie verzamelen (van bibliothecaris of encyclopedie-redacteur naar internet) en het nemen van aankoopbeslissingen (van letterlijke mond-tot-mondreclame naar klantbeoordeling op een webpagina). We vertrouwen op gegevens op ons scherm in plaats van op het oordeel of vermogen van een levend medemens. En in plaats van ervaringen met echte mensen te delen, delen we data via systemen. Software is eating the world.

Pikant detail is dat de conversaties die nu worden gevoerd in customer service het ideale leermateriaal zijn voor de invoelende robot. Veel van deze gesprekken worden digitaal vastgelegd, inclusief schermhandelingen. Daarnaast wordt vaak aan klanten gevraagd een oordeel te geven over de interactie in de vorm van een klanttevredenheidscijfer. Op deze manier lijken contactcentermedewerkers mee te werken aan de automatisering van hun eigen werk. Wellicht geldt dat straks voor meer beroepen.