We praten wat af in ons leven. Een van de belangrijkste (en ook meest ingewikkelde) dingen die een mens kan, is communiceren. We hebben hiervoor de beschikking over sociale vaardigheden, verbale uitdrukkingsvaardigheid (woordenschat, grammaticale kennis) en invoelend vermogen (om taal van een ander, maar ook de non-verbale communicatie te begrijpen). We herkennen ook gezichten, zodat we iemand als persoon kunnen plaatsen: onze leidinggevende, ons kind, onze vrienden. Er is voor mensen weinig reden om die communicatie te automatiseren, al zijn er ouders die hun kinderen toevertrouwen aan ‘connected‘ speelgoed waarmee ze interactie kunnen aangaan.

We praten wat af in ons leven. Een van de belangrijkste (en ook meest ingewikkelde) dingen die een mens kan, is communiceren. We hebben hiervoor de beschikking over sociale vaardigheden, verbale uitdrukkingsvaardigheid (woordenschat, grammaticale kennis) en invoelend vermogen (om taal van een ander, maar ook de non-verbale communicatie te begrijpen). We herkennen ook gezichten, zodat we iemand als persoon kunnen plaatsen: onze leidinggevende, ons kind, onze vrienden. Er is voor mensen weinig reden om die communicatie te automatiseren, al zijn er ouders die hun kinderen toevertrouwen aan ‘connected‘ speelgoed waarmee ze interactie kunnen aangaan.

Voor bedrijven ligt dat anders. Zij automatiseren graag zo een zo groot mogelijk deel van de interactie met klanten. Verschillende wetenschappers en softwareontwikkelaars zijn met bezig om de afzonderlijke bouwstenen van menselijke communicatie te vatten in algoritmen en geautomatiseerde systemen. Wat heb je nodig om een goed gesprek te voeren met een computer of robot?

Spraakherkenning

Allereerst moet de computer menselijke, natuurlijke taal kunnen herkennen. Deze technologie is inmiddels goed doorontwikkeld. Computers kunnen gesproken tekst vrijwel net zo goed omzetten in geschreven tekst als professionele transcribeerders. Dat spraakherkenning goed werkt, kan je testen met Siri of Google’s assistent op je eigen smartphone of de demo van Google’s Deepmind. De ‘last mile’ is echter nog lastig. Het gaat daarbij om het begrijpen van context, maar ook om het correct plaatsen van punten en komma’s. Spraakherkenning zou wellicht verbeterd kunnen worden als het gecombineerd wordt met systemen die liplezen.

Liplezen is voor mensen een flinke uitdaging. Een geoefende professional komt niet verder dan 60 procent correcte herkenning. LipNet, een systeem ontwikkeld door wetenschappers van Oxford University, haalt 93 procent accuratesse. De ontwikkelaars zien onder andere mogelijkheden op het vlak van ‘stil dicteren’, maar stellen ook dat spraakherkenning er verder mee verbeterd kan worden. LipNet werd getraind met bijna 29.000 video’s, gecombineerd met de juiste tekst. Het algoritme kan analyseren tot op losse letters. LipNet werd onder meer gefinancierd door DeepMind, de kunstmatige intelligentie-tak van Google.

Met wie spreek ik? Gezichtsherkenning

Gezichtsherkenning bestaat al geruime tijd. Het wordt bijvoorbeeld toegepast bij de douane van Schiphol voor identificatiedoeleinden. In de selfserviceomgeving van de luchthaven wordt nu al de scan van het paspoort vergeleken met het portretbeeld van de passagier, maar Schiphol wil nog een stap verder gaan en gezichtsherkenning uitbreiden over het gehele traject van vertrekhal tot in het vliegtuig.

Het herkennen van emoties

Emoties spelen een belangrijke rol in beslisprocessen van mensen. Interessant dus voor bedrijven die iets willen verkopen. Dat begint al bij marketing, wat probeert in te spelen op ons gevoel. Bij het beslissen over een aankoop worden moties en rationele afwegingen tegen elkaar afgezet. Wanneer een systeem de emotie van een klant kan herkennen, ben je al halverwege de portemonnee van die klant. In 2012 werden de eerste veelbelovende resultaten geboekt met een algoritme waarmee de computer de vorm van de mond van een computergebruiker kan koppelen aan de emoties (geluk, verdriet, angst, woede, walging en verbazing) die de gebruiker voelt. Het algoritme was zelflerend: het werd beter naarmate er meer voorbeelden werden aangereikt.

Volgens de analisten van MarketsandMarkets wordt er ook nu nog steeds veel geld in technologie voor emotiedetectie gepompt: 22 miljard dollar tot 2020. Bedrijven doen hun best om systemen te ontwikkelen die emoties kunnen aflezen van gezichten. Emotient werd begin dit jaar overgenomen door Apple – het zou zo maar kunnen dat je iPhone over een tijdje naar je gezicht kijkt en dat Siri bij het beantwoorden van je vragen rekening houdt met je gemoedstoestand.

Microsoft biedt een emotie-API aan, waarbij de API boosheid, zorgen, afgrijzen, angst, blijdschap, verdriet en verrassing gewogen kan beoordelen. Deze API kan je zelf testen door een foto te uploaden. Het idee achter de API is dat de uitkomst (de waarschijnlijkheid dat een bepaalde emotie aan de orde is) als input voor een ander systeem kan worden gebruikt. Er zijn nog tientallen andere oplossingen ontwikkeld voor emotie-detectie. Een daarvan is Affectiva, een oplossing die aan de hand van camerabeelden van oogopslag en wenkbrauwen op basis van machine learning real time emoties kan benoemen. De software wordt onder andere gebruikt door game developers en filmmakers om de beleving van de gebruiker verder te personaliseren.

Informatie uit emoties kan ook via spraakherkenning worden geanalyseerd. Spraaktechnologie kan behoorlijk goed overweg met de vier basis-emoties (boos, blij, bang en bedroefd) door te kijken naar een groot aantal eigenschappen van de spraak, waaronder toonhoogte, intonatie, tempo en volume.

Het kunnen vertonen van empathisch gedrag is met al deze technologie nog niet gerealiseerd. Daarvoor is empathie te complex: een systeem kan bijvoorbeeld nog geen onderscheid maken tussen een grapje, sarcasme of cynisme. Empathie is voor een groot deel ook cultureel bepaald. Het staat onder invloed van religie, land en taal.

Impliciete kennis en begrip van de context

Waag het niet een persoonlijke vraag aan Siri of een andere assistent te stellen – ‘Wat vind je dat mij beter staat, een hoed of een pet?’ of ‘Waarom ben ik altijd te laat voor mijn afspraken?’. De virtuele assistenten kunnen alleen overweg met de informatie die door de ontwikkelaars wordt aangeboden of ontsloten. Toen Watson de kennisquiz Jeopardy won, beschikte dat systeem over een extreem uitgebreide dataset. Zo’n dataset blijft echter expliciete kennis (denk aan het internet of een gesloten database zoals alle medisch-wetenschappelijke literatuur) die bovendien actueel moet worden gehouden.

Voor zinvolle persoonlijke interacties is ook impliciete kennis nodig. Die categorie kennis zit alleen in hoofden van mensen. Ook hebben kunstmatige intelligentie-systemen veel moeite met ambigue informatie. Het voorbeeld dat Arjan van Hessen aangeeft (Jan ziet Marie met een verrekijker) is een mooi voorbeeld. Een systeem zal ambigue zinnen moeten herkennen en in staat moeten zijn de juiste contextuele informatie te vinden (of op te vragen aan de gebruiker).

De sprekende computer: text-to-speech

Tot slot: een computer die je verbaal wilt laten communiceren met mensen, zal zelf ook tekst naar spraak moeten kunnen omzetten. Ook deze spraaksynthese-technologie is enorm verbeterd. Waar voorheen met blokjes spraak werd gewerkt (waardoor een sprekende computer nogal kunstmatig en houterig over kwam) worden nu veel kleinere eenheden geanalyseerd, gecodeerd en gebruikt om spraak te produceren.

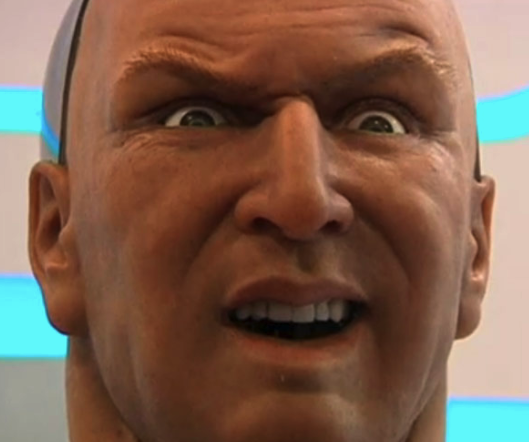

Op weg naar de uncanny valley

De oplossing die alle bovenstaande technologieën weet te combineren in bijvoorbeeld een robot met een levensecht uiterlijk, een goede motoriek en realistische gelaatsuitdrukkingen, komt dicht in de buurt van Westworld. Het is niet ondenkbaar dat over een paar jaar het onderscheid tussen mensen en robots – bijvoorbeeld bij toepassing van videoconversaties – op het eerste oog moeilijk te maken is. Naarmate het verschil tussen robots en mensen kleiner wordt, komt de ‘uncanny valley‘ steeds meer op de voorgrond: een afkeer van robots, omdat ze te veel menselijke trekjes krijgen.